- App come Headspace e Calm, lanciate rispettivamente nel 2010 e 2012, offrono meditazione guidata.

- Uno studio del 2024 ha mostrato vissuti di perdita dopo la rimozione di funzionalità romantiche da Replika.

- Youper mostra risultati positivi su ansia e depressione in sole 2 settimane.

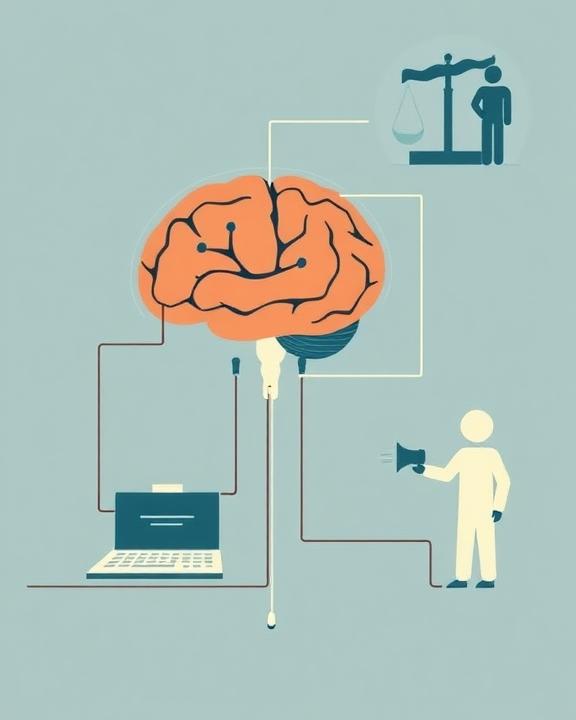

L’inesorabile avanzamento delle tecnologie moderne sta trasformando radicalmente il panorama della salute mentale; l’intelligenza artificiale (AI) si profila sempre più come un protagonista cruciale in tale ambito sensibile. La crescente incidenza dei disturbi quali ansia, depressione ed episodi prolungati di stress – fattori amplificati dalla recente crisi sanitaria globale – ha dato origine a una domanda considerevole nei confronti del sostegno psicologico. In tale contesto emergono soluzioni digitalizzate supportate dall’AI come risposte apparentemente rapide ed accessibili alle esigenze contemporanee: fanno capolino applicazioni orientate alla mindfulness, chatbot capaci d’empatizzare con l’utente grazie all’interazione automatizzata ma calorosa; nonché piattaforme dedicate alla telepsicologia insieme a simulazioni conversazionali sofisticate: strumenti tesi ad abbattere barriere storicamente presenti nell’approccio ai servizi psichiatrici classici — dal peso economico dell’assistenza al mancato tempo da dedicare agli spostamenti fino al timore derivante dal giudizio sociale.

Tuttavia, questo incremento nel settore della salute mentale digitale porta con sé interrogativi irrisolti. Da un lato, il bisogno impellente incita milioni – soprattutto tra i membri dei millennials – ad intrattenere conversazioni virtuali tramite chatbot nella lotta contro stati d’animo avversativi quali ansia o isolamento emotivo, così come anche nelle complessità delle loro relazioni sociali; dall’altro emerge la cruciale questione riguardante le caratteristiche intrinseche dell’interazione umana veicolata attraverso queste nuove tecnologie e le eventualità problematiche legate ai loro limiti funzionali. È cruciale comprendere la differenza tra un trattamento psicologico condotto da un professionista e un’esperienza digitale di supporto emotivo. Quali sono i confini etici e clinici dell’affidare a un algoritmo una funzione intrinsecamente relazionale e umana?

Il mercato offre oggi una vasta gamma di strumenti. Tra i più diffusi troviamo le app di autoaiuto e wellness, come Headspace e Calm. Fondate rispettivamente nel 2010 e nel 2012, queste applicazioni propongono percorsi di meditazione guidata, esercizi di respirazione e tecniche di rilassamento, ispirandosi alla psicologia positiva. Nonostante la loro popolarità e un’estetica curata, mancano ancora prove solide sulla loro efficacia clinica a lungo termine. Le metriche di valutazione si concentrano spesso sull’engagement degli utenti, piuttosto che su indicatori di salute mentale validati.

| App | Funzionalità | Anno di Lancio |

|---|---|---|

| Headspace | Meditazione guidata, esercizi di respirazione | 2010 |

| Calm | Rilassamento, storie per il sonno | 2012 |

| Woebot | Supporto emotivo, terapia cognitivo-comportamentale | 2017 |

| Wysa | Supporto umano, gestione delle emozioni | 2016 |

| Replika | Compagno AI personalizzabile | 2017 |

Accanto alle app, i chatbot conversazionali rappresentano un’altra frontiera dell’AI per il benessere mentale. Fin dal 1966, con l’introduzione di ELIZA da parte di Joseph Weizenbaum, si è cercato di simulare il linguaggio naturale in un contesto terapeutico. Oggi, grazie ai modelli linguistici avanzati (LLM), questa simulazione è notevolmente più realistica. Chatbot come Woebot, Wysa e Replika offrono supporto emotivo e suggerimenti comportamentali, basandosi spesso sulla terapia cognitivo-comportamentale (CBT).

Woebot, sviluppato dalla Stanford University, e Wysa, con le sue opzioni di supporto umano a pagamento, mirano a modificare le distorsioni cognitive. Replika, invece, si spinge oltre, proponendosi come un “AI companion” generalista e personalizzabile, anche in senso romantico o sessualizzato, sollevando importanti questioni etiche e psicologiche legate ai rischi di dipendenza emotiva e confusione affettiva. Uno studio longitudinale del 2024 ha evidenziato come la rimozione di funzionalità romantiche da Replika abbia generato negli utenti vissuti di perdita e frustrazione, a riprova della profondità del legame simulato. Ulteriori soggetti informali nel panorama tecnologico, come il fenomeno del Broken Bear AI, offrono un senso di sollievo, senza intenti terapeutici ben definiti; ciò sfuma ulteriormente i limiti tra l’empatia generata da algoritmi e la reale assistenza umana.

Sintetizzando il discorso principale: le capacità dell’intelligenza artificiale forniscono una versione emulativa dell’empatia, benché avanzata sia priva di consapevolezza e intento specifico. Tali strumenti replicano modelli linguistici interiorizzati ma non riescono a captare in modo genuino le sfumature delle emozioni umane. Riguardo la tematica della sicurezza dei dati personali connessa agli stati emotivi individuali, essa si pone con evidenza data la mancanza di trasparenza relativa ai metodi impiegati per raccogliere ed elaborare tali informazioni riservate.

I modelli ibridi e le sfide etiche nell’AI per la salute mentale

L’armonizzazione degli algoritmi digitali con l’intervento dei professionisti nel campo della salute mentale ha dato origine a una nuova categoria d’innovazione: le piattaforme ibride. Esempi come Youper, Talkspace e BetterHelp rappresentano una fusione ottimale delle diverse risorse disponibili. Questi servizi propongono itinerari terapeutici individualizzati con un accesso tempestivo ai supporti necessari a costi possibilmente inferiori rispetto a quelli tipici della psicoterapia convenzionale. Prendiamo il caso specifico di Youper: questo strumento ha evidenziato notevoli risultati positivi nella gestione dell’ansia e della depressione già dopo sole due settimane dall’inizio del suo utilizzo, grazie all’uso innovativo di un chatbot fondato sulla CBT affiancata da consultazioni umane. Analogamente, anche piattaforme come Talkspace e BetterHelp forniscono sessioni condotte da terapeuti certificati e hanno dimostrato avanzamenti clinici attraverso ricerche longitudinalmente condotte sui temi dell’ansia e della depressione. Resta però aperta la questione riguardante la reale efficacia dell’approccio digitale in comparazione agli interventi faccia a faccia.

A fronte delle concrete opportunità legate all’aumento dell’accessibilità – aspetto cruciale soprattutto nei contesti dove i servizi psichiatrici sono limitati – sorgono tuttavia interrogativi critici sull’affidabilità di queste piattaforme. L’interazione terapeutica facilitata da tecnologie digitali e attraverso specifiche linee guida potrebbe rivelarsi decisamente meno fruttuosa ed assumere connotazioni sempre più sconnesse dal personale umano. L’efficacia del trattamento si manifesta significativamente in base alla preparazione dei professionisti coinvolti e alla loro abilità nel navigare all’interno di queste strutture composite. Ci sono anche dubbi circa la tutela della privacy delle informazioni cliniche, la lucidità degli algoritmi destinati ad abbinare terapeuti a pazienti, insieme alle normative legali ed etiche circostanti queste piattaforme.

Uno degli aspetti fondamentali è rappresentato dall’assenza di appropriati meccanismi iniziali per la valutazione degli utenti: questi dovrebbero fungere da strumenti idonei per rilevare il profilo emotivo dell’individuo nonché eventuali predisposizioni a disturbi psichiatrici prima dell’avvio della terapia. Tale carenza rischia infatti di far insorgere interventi terapeutici inadatti o indugi nel rinviare i pazienti verso trattamenti efficaci. Un caso emblematico illustrato su The Baffler coinvolge un’intelligenza artificiale denominata Broken Bear: questo chatbot suggeriva a una persona manifestante segni correlabili al disturbo ossessivo-compulsivo (TOC) semplicemente “di controllare il forno”. Questo episodio dimostra chiaramente le problematiche intrinseche nella mancanza di supervisione per soluzioni AI destinate alla salute mentale; piuttosto che attenuare tali condotte problematiche, potrebbe addirittura incoraggiarle ulteriormente. Le tecnologie di intelligenza artificiale possono manifestare insufficienze significative nel fornire risposte appropriate e presentarsi come potenzialmente pericolose a causa dei noti bias algoritmici. Questi pregiudizi sociali e psicologici trovano origine nei set di dati impiegati per addestrare gli algoritmi stessi. Essi incarnano concezioni distorte che riguardano la razza, il genere e altre peculiarità umane. Quando i set di training includono elementi discriminatori si verifica la loro replica da parte dell’intelligenza artificiale che li amplifica ulteriormente; ciò conduce inevitabilmente a diagnosi inesatte, terapie inadeguate e un acuirsi delle disuguaglianze.

In ambito sanitario è possibile rintracciare esempi concreti di bias nella tecnologia AI attraverso l’esistenza di algoritmi capaci di discriminare determinati gruppi all’interno della popolazione. Questo comporta effetti diretti sull’accuratezza diagnostica oltre che sulla personalizzazione delle cure proposte. L’insufficiente rappresentanza della diversità nei dati destinati all’addestramento si traduce in prestazioni inferiori dell’intelligenza artificiale stessa per specifiche categorie socio-demografiche quali le minoranze etniche o le donne; questo fenomeno compromette seriamente il principio dell’equità nell’assistenza sanitaria fornita. Il timore è quindi quello che tali innovazioni tecnologiche possano finire con il marginalizzare ulteriormente segmenti già svantaggiati della società.

- L'AI può democratizzare l'accesso alla salute mentale... 🚀...

- Trovo pericoloso affidarsi completamente all'AI per la salute mentale... ⚠️...

- E se l'AI potesse sbloccare nuove comprensioni della mente umana... 🤔...

NeuroMI 2025: L’intelligenza Artificiale tra opportunità e responsabilità

Il congresso NeuroMI 2025 si prospetta come una tappa fondamentale per esaminare criticamente il ricorso all’Intelligenza Artificiale nel contesto della diagnosi e cura delle patologie mentali. Una varietà eterogenea composta da esperti del settore AI, medici specialisti in psichiatria, neuroscienziati e filosofi sarà presente per analizzare i potenziali rischi insieme alle promettenti opportunità che caratterizzano questo ambito in rapido sviluppo.

In primo luogo, vi è da considerare che l’AI possiede potenziali straordinari. Essa è capace d’intensificare la precisione nelle diagnosi mediante lo studio approfondito d’ingenti moli di dati volti all’individuazione di schemi complessi difficilmente percepibili dall’occhio umano. L’abilità nell’adattamento delle terapie alle necessità particolari e ai riscontri individuali dei pazienti rappresenta senza dubbio un notevole progresso verso una medicina su misura, estendendo la sua validità anche nell’ambito della salute mentale. Ulteriormente interessante è il monitoraggio remoto degli assistiti tramite strumenti tecnologici avanzati come sensori o applicazioni mobili; tale modalità permetterebbe non solo interventi tempestivi ma altresì prevenzione attiva nell’intercettazione dei segnali premonitori d’aggravamento clinico prima del sorgere delle crisi.

Contemporaneamente però sussistono numerose problematiche etiche e intellettive, inerenti al ruolo dell’AI stesso nel campo medico-psichiatrico; esse necessitano quindi d’un’approfondita analisi critica. Il rischio di bias algoritmici, già evidenziato, può portare a discriminazioni sistemiche, compromettendo l’equità e l’efficacia delle cure. La mancanza di trasparenza nei processi decisionali dell’AI, il cosiddetto “problema della scatola nera”, solleva interrogativi sulla responsabilità in caso di errore diagnostico o terapeutico. È fondamentale capire come e perché un algoritmo giunge a determinate conclusioni, per poterne valutare l’affidabilità e l’impatto sulla vita dei pazienti.

L’impatto sull’autonomia del paziente e sulla relazione terapeutica è un’altra area di attenzione. Sebbene l’AI possa offrire un supporto prezioso, non può replicare la complessità e la profondità dell’interazione umana, che è al centro di ogni percorso di guarigione. L’illusione dell’empatia digitale, come dimostrano i casi di Replika, può portare a dipendenza emotiva e a una confusione affettiva che mina la capacità dell’individuo di costruire relazioni autentiche.

A fronte di queste criticità, è imperativo sviluppare un approccio critico, regolato e consapevole. Tale scenario richiede l’implementazione di un protocollo d’iniziale valutazione estremamente rigoroso, lo sviluppo di algoritmi dotati della necessaria trasparenza, oltre alla formulazione di un sistema normativo e deontologico ben definito, capace di salvaguardare i diritti e il rispetto della privacy degli utenti. L’intelligenza artificiale deve essere progettata prevalentemente come un mezzo per assistere i professionisti, piuttosto che rappresentare una mera sostituzione del giudizio clinico o delle dinamiche relazionali umane.

Oltre l’algoritmo: la complessità della mente umana

In un mondo sempre più permeato dall’intelligenza artificiale, la complessità della mente umana emerge come un faro insostituibile. La psicologia cognitiva ci ha insegnato che il nostro pensiero non è un mero calcolo razionale, ma è il risultato di processi complessi influenzati da emozioni, esperienze passate e bias cognitivi. Questi bias, lungi dall’essere semplici errori da eliminare, sono in realtà delle “scorciatoie” mentali, euristiche, che ci permettono di elaborare rapidamente le informazioni e prendere decisioni in un mondo complesso. Sono, in un certo senso, una testimonianza della nostra umanità, della nostra capacità di interpretare la realtà in modo unico e non replicabile dall’AI.

La psicologia comportamentale, d’altra parte, ci ricorda che le nostre azioni sono spesso determinate da un intreccio di condizionamenti ambientali e risposte apprese, che modellano il nostro modo di reagire agli stimoli, talvolta generando schemi disfunzionali. L’AI, addestrata su vasti set di dati che riflettono questi schemi umani, può replicare e persino amplificare tali bias, se non gestita con cautela. Tuttavia, proprio la consapevolezza di queste dinamiche può aiutarci a costruire strumenti AI che siano alleati, e non ostacoli, nel percorso verso il benessere mentale.

La medicina della salute mentale moderna ci mostra che la cura non è solo un atto tecnico, ma un processo relazionale profondo e complesso. La relazione terapeutica, basata sull’empatia, sull’ascolto attivo e sulla comprensione del contesto unico di ogni individuo, è un pilastro fondamentale. L’AI può offrire supporto, monitoraggio e accesso a informazioni preziose, ma non può sostituire la dimensione umana di questa relazione, che è essenziale per affrontare traumi e difficoltà, per costruire resilienza e per promuovere un cambiamento autentico. La sfida principale della modernità è, quindi, quella di coniugare il potenziale delle nuove tecnologie con la ricchezza e la profondità del pensiero umano. Non si tratta di eliminare ogni traccia di “bias” nel nostro processo decisionale o in quello dell’AI, ma piuttosto di comprenderli, di lavorare con essi e, in ultima analisi, di utilizzarli come un ponte tra il mondo dell’intelligenza artificiale e l’umanità, per garantire un futuro in cui la tecnologia sia al servizio del benessere, in tutte le sue sfaccettature.

- AI: Intelligenza Artificiale, campo dell’informatica che si occupa di creare sistemi capaci di svolgere compiti normalmente associati all’intelligenza umana.

- Chatbot: Programma che simula una conversazione con utenti umani, utilizzando l’elaborazione del linguaggio naturale.

- Telepsicologia: Pratica della psicologia che si svolge attraverso mezzi digitali, consentendo agli utenti di ricevere trattamento a distanza.